1. 环境简介

1.1硬件环境

准备4台物理服务器作为部署节点

进入主机BIOS,开启Intel(R) Virtualization Technology和Intel(R) VT forDirected I/O虚拟化支持功能。

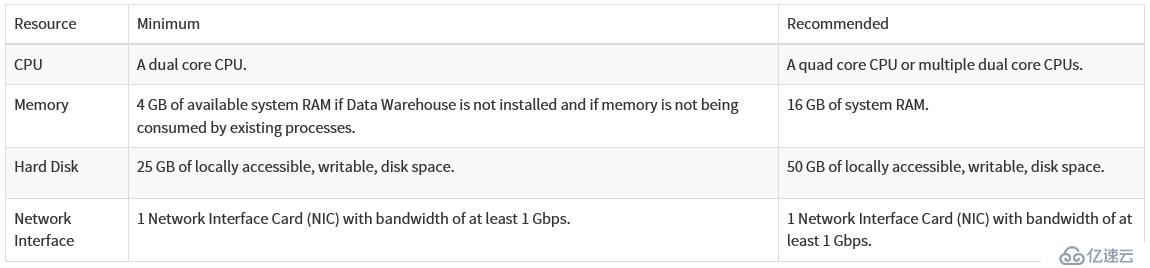

oVirt硬件环境官方需求如图。

1.2软件环境

所有服务器系统:CentOS7.3 minimal 64位

oVirt版本:4.1.1

2. oVirt简介

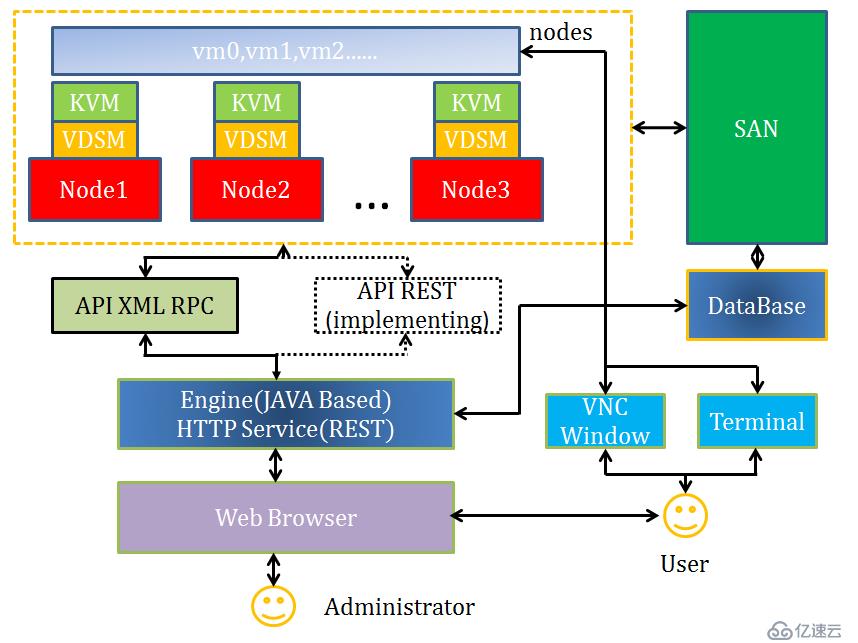

oVirt是基于KVM虚拟化组建私有云平台的管理工具。oVirt以web界面的方式管理KVM虚拟化环境,主要由Engine和Node两部分组成,Engine是oVirt中的管理节点,提供web界面与用户交互,使Node节点管理可视化。Node是oVirt中的计算节点,底层专注KVM虚拟化,并为虚拟机运行提供计算资源。oVirt是数据中心虚拟化管理平台解决方案,数据中心是逻辑的概念,按照主数据存储的组织方式划分,以便快速构建私有云,主要应用于桌面云和服务器虚拟化。

oVirt Engine负责整个系统的管理维护是整个oVirt管理平台的核心部件,Engine节点内置数据库记录整个系统中所有的虚拟机配置、节点状态、系统环境、存储器等信息。实现管理的逻辑、状态及策略,良好的web界面客户端,使系统管理员通过网页进行管理系统的任何操作。oVirt Node只负责提供计算资源及功能实现,不记录任何信息,仅仅负责实现虚拟机器与设备的创建与修改,资源的共享与保护。Node节点可以由普通Linux操作系统安装VDSM组件构成,也可以是专为Node定制的Linux操作系统。VDSM是维系Node节点与Engine关系的纽带,负责节点的自启动与注册及对网络、存储、主机、虚拟机的管理,支持对虚拟机的外部干涉、内存与存储的合并与超支等功能。Node节点系统重启后内容消失,从而保证了Node的无状态性。

oVirt官网:http://www.ovirt.org/

oVirt官网部署手册:

http://www.ovirt.org/documentation/install-guide/Installation_Guide/

3. 部署实践

根据oVirt方案架构图需求,要用3台服务器部署oVirt Node计算节点,1台服务器部署oVirt Engine管理节点。oVirt既可以安装在虚拟机中,也可以安装在物理服务器上。本次安装采用物理服务器,不推荐用虚拟机安装,用虚拟机安装时,安装好后运行虚拟机无法进入控制台页面。

3.1环境准备

部署底层系统

oVirt虚拟化所有服务都需要将Linux系统作为底层运行环境。因此,将四台物理服务器全部安装CentOS7.3 minimal 64位操作系统。配置好正确时间和时区(Shanghai)。

关闭所有主机防火墙:

#systemctl stop firewalld.service

#systemctl disable firewalld.service

修改主机名:

以engine为例,如下:

#hostnamectl --static set-hostname engine.taocloud.com

配置好其余Node节点主机名。

配置yum源

oVirt-Engine采用yum源的安装方式,配置所有主机的oVirt yum源,官网中所提供yum源下载速度过慢,因此不推荐使用。在每台服务器中分别执行如下命令:

sudo yum install http://mirror.isoc.org.il/pub/ovirt/yum-repo/ovirt-release41.rpm

Engine节点需要yum安装oVirt-Engine,Node节点需要部署VDSM与KVM服务。

3.2Engine管理节点

安装管理节点

Engine作为管理节点,是整个系统的核心部件,控制计算节点资源的使用,提供用户访问的web管理界面。

配置好所有yum源后安装oVirt-Engine管理节点,执行如下命令:

sudo yum install ovirt-engine –y

配置oVirt Engine

执行命令:ovirt-engine setup

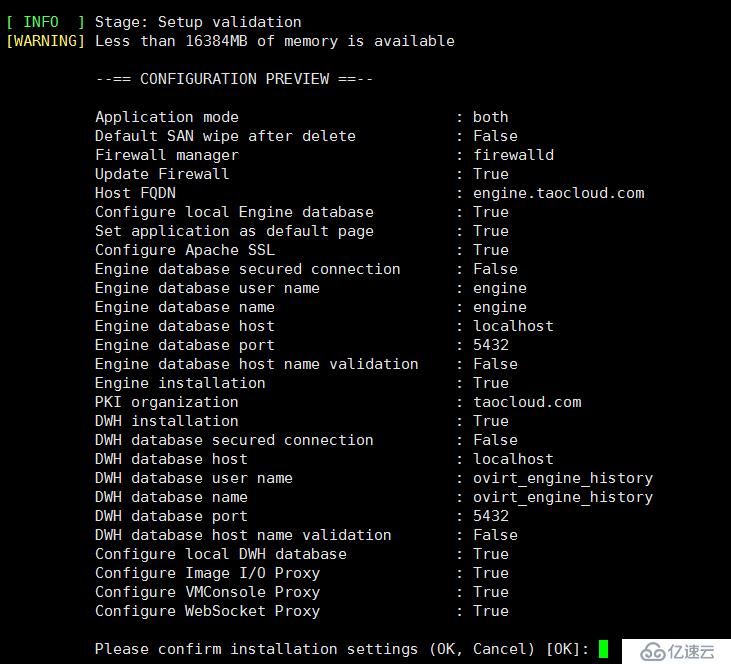

除部分需要填写的名称外,其余全部为默认,配置信息如下图所示。

登录Engine Web管理界面

Ovirt Engine使用FQDN方式进行web端访问,没有配置DNS时,需要修改远端Windows机器的hosts文件,如下图。

在远程windows端打开浏览器,输入:http://ovirtengine.taocloud.com/ovirt-engine进入oVirt WEB界面。用管理门户进行登录。

不修改hosts文件解析主机名时将无法正常名访问到WEB界面。

使用系统默认的数据中心,配置集群时选择共享存储方式

3.3Node计算节点

Ovirt Node支持两种部署方式,可由普通Linux系统安装VDSM和KVM服务组建Node节点,也可以在服务器之间安装oVirt Node定制的Linux操作系统。本次部署采用由普通Linux系统部署服务的方法。

安装计算节点

oVirt Node作为虚拟化环境的计算节点,负责提供计算资源,搭建时需要在Linux操作系统部署VDSM和KVM服务。安装服务前需要确保服务器具备以下条件:

能ping通外网

yum源配置正确

执行命令: # setenforce 0 #关闭SElinux

#vi /etc/selinux/config #修改配置文件,保证重启后状态不变

#SELINUX =enforcing #注释掉改行内容,并在其下部添加信息

SELINUX=permissive

保存退出后。执行命令: #getenforce

Permissive #返回该结果说明配置正确

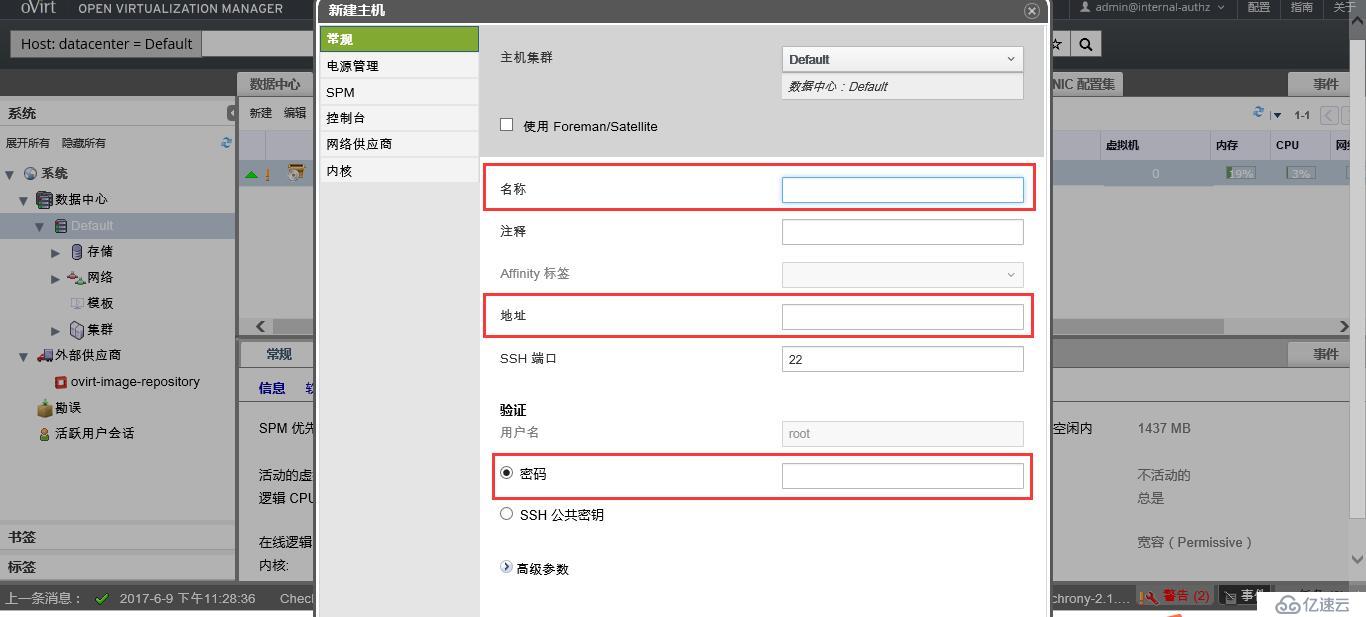

以上条件满足后,回到Engine管理界面,通过ip直接添加oVirt Node节点,名称随意写可用ip代替,一定要输入正确的节点ip和验证密码,其余内容根据个人需求填写。等待一段时间后,即完成oVirt Node安装,确保以上条件满足时安装过程中可能有警告但不会报错。

Node定制镜像

ovirt官网下载Node定制Linux系统镜像:

ovirt-node-ng-installer-ovirt-4.1-2017041904.iso

把该系统镜像直接部署在Node服务器上,之后之间在Engine管理界面添加Node节点。

3.4存储域

配置nfs存储

oVirt集群有本地存储与共享存储两种方式,选择本地存储时集群中只能添加单台Node节点,所以为了更好发挥集群特性,采用nfs共享存储方式,在每台Node节点上配置nfs共享存储用于安装虚拟机,执行以下命令:

mkdir /export/iso #创建iso存储域用于存放系统镜像

mkdir /export/data #创建data存储域用于存放虚拟机数据

chown 36:36 –R /export #赋予VDSM权限

chmod 0755 –R /export #赋予执行权限

cat /etc/exports #按照以下内容编辑exports文件

/export/ iso *(rw,sync,no_subtree_check,all_squash,anonuid=36,anongid=36)

/export/ data*(rw,sync,no_subtree_check,all_squash,anonuid=36,anongid=36)

systemctl start nfs.service #启动nfs服务

systemctl enable nfs.service #设置nfs服务开机自启动

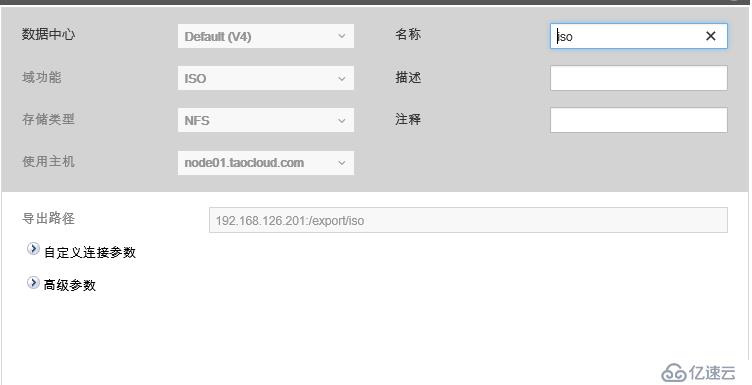

添加NFS存储

在oVirt存储域管理界面新建data存储域用于存放数据,再新建ISO存储域用于存放虚拟机镜像,根据页面提示填写好正确的存储路径及其它信息。

上传镜像

在界面添加好iso存储域和data数据存储域后,可将系统镜像直接拷贝到/export/ iso/98e1a52b-b72f-40f5-8c3e-f1cbb8989b93/p_w_picpaths/11111111-1111-1111-1111-111111111111目录下,拷贝完成后在前台界面刷新即可使用。

3.5虚拟机

创建虚拟机

创建虚拟机时一定要至少附件或创建一个实例镜像即虚拟机系统盘,至少添加一个网络,编辑好规格需求后点击确定。

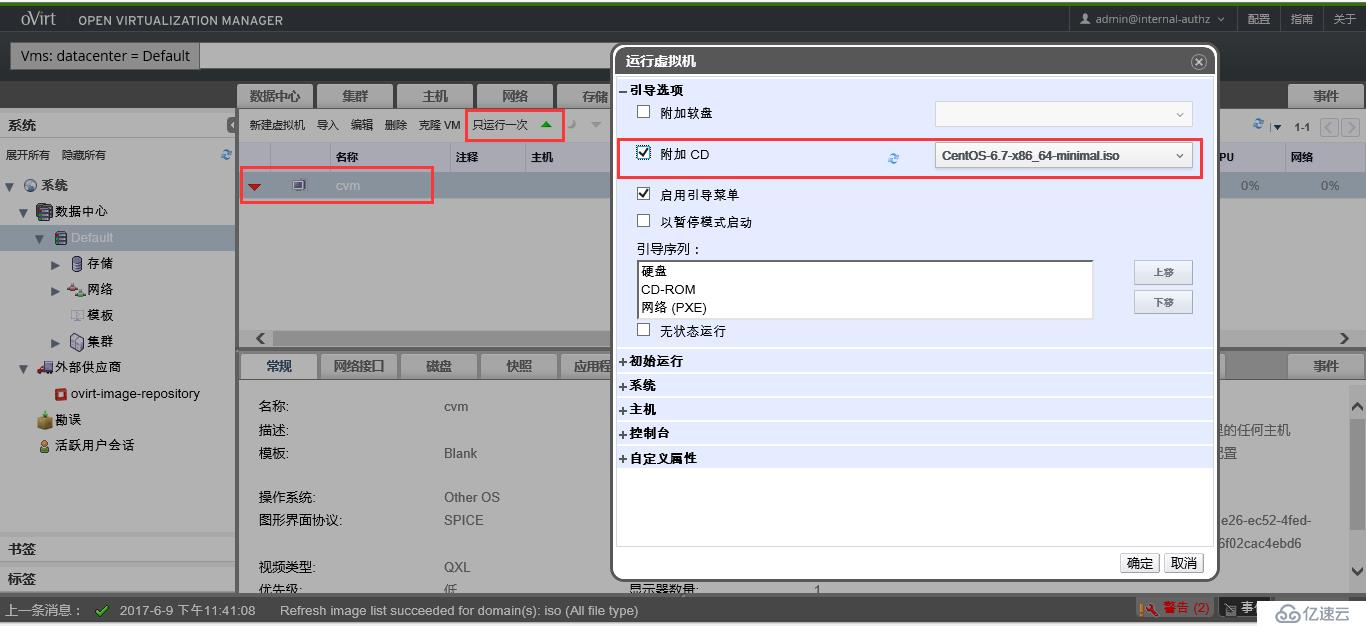

在虚拟机列表界面选中虚拟机后点击“只运行一次”,进入引导选项选择相应的系统镜像,之后便可打开控制台进行操作系统安装。

4. 常见问题

错误1:

执行yum install ovirt-engine时若有任何报错,检查yum源是否有问题,一般yum源配置正确不会出现错误,无法确定的情况下尝试更换yum源。

错误2:

在管理界面添加Node节点时报错:

Host installation failed. Command returnedfailure code 1 during SSH session 'root@192.168.*.*'

解决:

(1)查看/etc/yum.repos.d里面的ovirt源是否齐全,必须有ovirt-4.1-dependencies.repo和ovirt-4.1.repo,以及CentOS-*,以下为正常源。

[root@node01 ~]# ls /etc/yum.repos.d/

bak CentOS-Debuginfo.repo CentOS-Sources.repo ovirt-4.1.repo

CentOS-Base.repo CentOS-fasttrack.repo CentOS-Vault.repo server.repo

CentOS-CR.repo CentOS-Media.repo ovirt-4.1-dependencies.repo

可执行yum clean all清理yum源缓存。

(2)查看是否能ping通外网

(3)/etc/init.d/rpcbind restart /etc/init.d/vdsmd restart

(4)检测firewalld与selinux状态,如果依然添加失败可尝试执行:

在Node节点添加失败的任何情况下都可按照此方法排查。

错误3:

挂载nfs失败时,进入底层用指令测试:

[root@node1 ~]# showmount -e 192.168.3.233

rpc mount export: RPC: Unable to receive;errno = No route to host

关闭firewalld和iptables

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。