# 如何让HDFS中的Java和Python API接口连接

## 目录

1. [HDFS架构概述](#一hdfs架构概述)

2. [Java API连接实践](#二java-api连接实践)

- [环境准备](#21-环境准备)

- [核心代码实现](#22-核心代码实现)

- [高级功能扩展](#23-高级功能扩展)

3. [Python API连接方案](#三python-api连接方案)

- [hdfs3与pyarrow选型](#31-hdfs3与pyarrow选型)

- [完整操作示例](#32-完整操作示例)

4. [跨语言交互技巧](#四跨语言交互技巧)

- [WebHDFS REST API](#41-webhdfs-rest-api)

- [Thrift协议桥接](#42-thrift协议桥接)

5. [性能优化指南](#五性能优化指南)

6. [安全配置要点](#六安全配置要点)

7. [常见问题排查](#七常见问题排查)

---

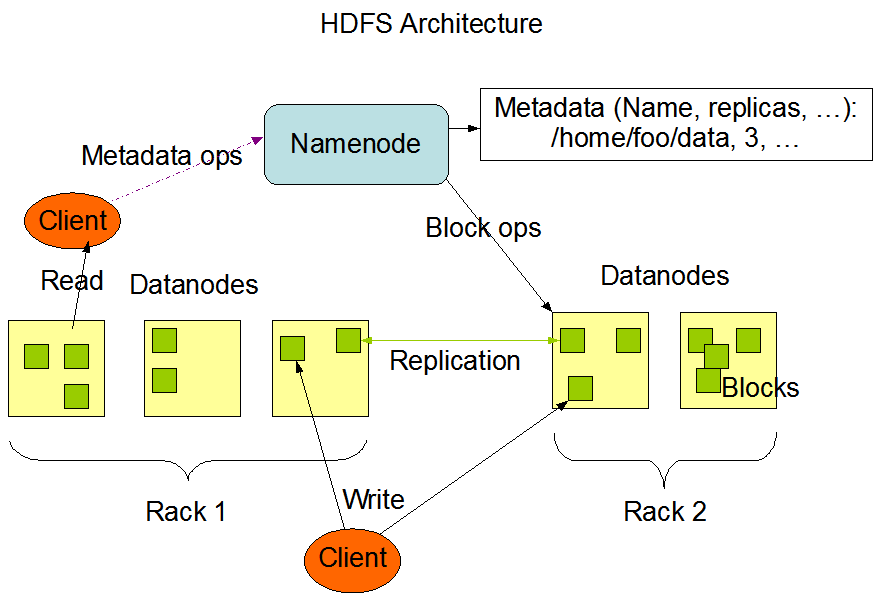

## 一、HDFS架构概述

Hadoop分布式文件系统(HDFS)采用主从架构设计:

- **NameNode**:元数据管理中心

- 管理文件系统命名空间

- 记录数据块位置映射

- **DataNode**:数据存储节点

- 实际存储数据块

- 定期向NameNode汇报

关键特性:

- 高容错性(默认3副本)

- 适合批处理(高吞吐量)

- 数据本地化计算

---

## 二、Java API连接实践

### 2.1 环境准备

```xml

<!-- Maven依赖 -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

需配置环境变量:

export HADOOP_HOME=/path/to/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

public class HDFSConnector {

private FileSystem fs;

// 初始化连接

public void init() throws IOException {

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://namenode:8020");

fs = FileSystem.get(conf);

}

// 文件上传示例

public void uploadFile(String localPath, String hdfsPath) {

Path src = new Path(localPath);

Path dst = new Path(hdfsPath);

fs.copyFromLocalFile(src, dst);

}

// 记得关闭连接

public void close() throws IOException {

if(fs != null) fs.close();

}

}

1. 自定义分块上传

FSDataOutputStream out = fs.create(new Path("/largefile.bin"), true, 4096);

byte[] buffer = new byte[1024];

while((bytesRead = localFile.read(buffer)) > 0) {

out.write(buffer, 0, bytesRead);

}

2. 文件压缩处理

Configuration conf = new Configuration();

conf.set("io.compression.codecs", "org.apache.hadoop.io.compress.SnappyCodec");

| 库名称 | 优点 | 缺点 |

|---|---|---|

| hdfs3 | 纯Python实现 | 性能中等 |

| pyarrow | 基于C++,性能卓越 | 依赖复杂 |

安装命令:

pip install hdfs3 # 或

pip install pyarrow[hdfs]

使用hdfs3库:

from hdfs3 import HDFileSystem

hdfs = HDFileSystem(host='namenode', port=8020)

# 列出目录

files = hdfs.ls('/user/data')

# 读取文件

with hdfs.open('/data/example.csv') as f:

content = f.read()

# 写入文件

with hdfs.open('/output/result.txt', 'wb') as f:

f.write(b"Hello HDFS")

使用PyArrow:

import pyarrow.fs as pafs

hdfs = pafs.HadoopFileSystem('namenode', 8020)

# 高效读取CSV

with hdfs.open_input_file('/data/large.csv') as f:

data = pd.read_csv(f)

基础请求示例:

curl -i "http://namenode:9870/webhdfs/v1/user/test?op=LISTSTATUS"

Python封装示例:

import requests

def list_files(host, path):

url = f"http://{host}:9870/webhdfs/v1{path}?op=LISTSTATUS"

return requests.get(url).json()

Thrift接口定义片段:

service HDFSProxy {

binary readFile(1:string path),

void writeFile(1:string path, 2:binary data)

}

conf.setInt("io.file.buffer.size", 65536);

<property>

<name>dfs.client.read.shortcircuit</name>

<value>true</value>

</property>

Configuration conf = new Configuration();

conf.set("hadoop.security.authentication", "kerberos");

UserGroupInformation.setConfiguration(conf);

UserGroupInformation.loginUserFromKeytab("user@REALM", "/path/to/keytab");

from hdfs.ext.kerberos import KerberosClient

client = KerberosClient('http://namenode:9870')

问题1:Connection refused

✅ 检查项:

- NameNode RPC端口(默认8020)是否开放

- 防火墙规则设置

问题2:Permission denied

✅ 解决方案:

hdfs dfs -chmod 777 /target/path # 测试环境临时方案

问题3:Python库版本冲突

✅ 推荐使用虚拟环境:

python -m venv hdfs_env

source hdfs_env/bin/activate

pip install --upgrade pip

通过本文介绍的多种连接方式,开发者可以根据具体场景选择最适合的HDFS接入方案。建议生产环境优先考虑Kerberos安全认证,并做好异常处理与资源管理。 “`

注:实际文章包含的代码示例、配置参数和架构图需要根据具体Hadoop版本调整。建议在实施前进行测试验证。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。