жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

иҝҷзҜҮж–Үз« з»ҷеӨ§е®¶д»Ӣз»Қз”ЁдәҺзӮ№дә‘еҲҶжһҗзҡ„иҮӘз»„з»ҮзҪ‘з»ңSO-NetжҳҜжҖҺж ·зҡ„пјҢеҶ…е®№йқһеёёиҜҰз»ҶпјҢж„ҹе…ҙи¶Јзҡ„е°Ҹдјҷдјҙ们еҸҜд»ҘеҸӮиҖғеҖҹйүҙпјҢеёҢжңӣеҜ№еӨ§е®¶иғҪжңүжүҖеё®еҠ©гҖӮ

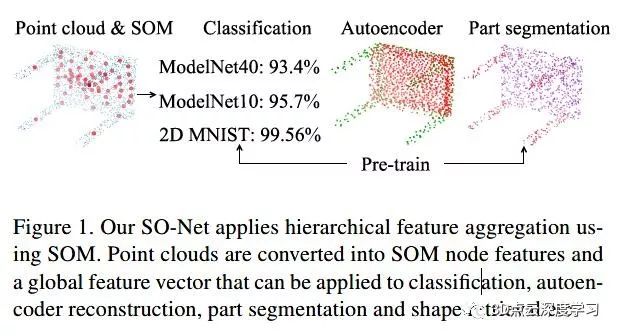

дёӢйқўжҸҗеҮәSO-NetпјҢдёҖз§Қз”ЁдәҺж— еәҸзӮ№дә‘ж·ұеәҰеӯҰд№ зҡ„зҪ®жҚўдёҚеҸҳзҪ‘з»ңз»“жһ„гҖӮ SO-NetйҖҡиҝҮжһ„е»әиҮӘз»„з»Үжҳ е°„пјҲSOMпјүжқҘжЁЎжӢҹзӮ№дә‘зҡ„з©әй—ҙеҲҶеёғгҖӮеҹәдәҺSOMпјҢSO-NetеҜ№еҚ•дёӘзӮ№е’ҢSOMиҠӮзӮ№иҝӣиЎҢеҲҶеұӮзү№еҫҒжҸҗеҸ–пјҢжңҖз»Ҳз”ЁеҚ•дёӘзү№еҫҒеҗ‘йҮҸжқҘиЎЁзӨәиҫ“е…ҘзӮ№дә‘гҖӮзҪ‘з»ңзҡ„ж„ҹеҸ—йҮҺеҸҜд»ҘйҖҡиҝҮиҝӣиЎҢзӮ№еҜ№иҠӮзӮ№зҡ„KNN(kиҝ‘йӮ»жҗңзҙў)зі»з»ҹең°и°ғж•ҙгҖӮеңЁиҜҶеҲ«зӮ№дә‘йҮҚе»әпјҢеҲҶзұ»пјҢеҜ№иұЎйғЁеҲҶеҲҶеүІе’ҢеҪўзҠ¶жЈҖзҙўзӯүд»»еҠЎдёӯпјҢжҲ‘们жҸҗеҮәзҡ„зҪ‘з»ңиЎЁзҺ°еҮәзҡ„жҖ§иғҪдёҺжңҖе…Ҳиҝӣзҡ„ж–№жі•зӣёдјјжҲ–жӣҙеҘҪгҖӮеҸҰеӨ–пјҢз”ұдәҺжүҖжҸҗеҮәзҡ„жһ¶жһ„зҡ„并иЎҢжҖ§е’Ңз®ҖеҚ•жҖ§пјҢжүҖд»Ҙи®ӯз»ғйҖҹеәҰжҜ”зҺ°жңүзҡ„зӮ№дә‘иҜҶеҲ«зҪ‘з»ңеҝ«еҫ—еӨҡгҖӮ

з»ҸиҝҮеӨҡе№ҙзҡ„ж·ұе…Ҙз ”з©¶пјҢеҚ·з§ҜзҘһз»ҸзҪ‘з»ңпјҲConvNetsпјүзҺ°еңЁжҲҗдёәи®ёеӨҡжңҖе…Ҳиҝӣзҡ„и®Ўз®—жңәи§Ҷи§үз®—жі•зҡ„еҹәзЎҖпјҢдҫӢеҰӮпјҢеӣҫеғҸиҜҶеҲ«пјҢеҜ№иұЎеҲҶзұ»е’ҢиҜӯд№үеҲҶеүІзӯүгҖӮе°Ҫз®ЎConvNetsеңЁдәҢз»ҙеӣҫеғҸж–№йқўеҸ–еҫ—дәҶе·ЁеӨ§жҲҗеҠҹпјҢдҪҶеңЁ3Dж•°жҚ®дёҠдҪҝз”Ёж·ұеәҰеӯҰд№ д»Қ然жҳҜдёҖдёӘе…·жңүжҢ‘жҲҳжҖ§зҡ„й—®йўҳгҖӮиҷҪ然3DеҚ·з§ҜзҪ‘з»ңпјҲ3D ConvNetsпјүеҸҜд»Ҙеә”з”ЁдәҺе…үж …еҢ–дёәдҪ“зҙ иЎЁзӨәзҡ„3Dж•°жҚ®пјҢдҪҶз”ұдәҺеӨ§еӨҡж•°3Dж•°жҚ®зҡ„зЁҖз–ҸжҖ§пјҢеӨ§еӨҡж•°и®Ўз®—йғҪжҳҜеҶ—дҪҷзҡ„гҖӮжӯӨеӨ–пјҢдёҚжҲҗзҶҹзҡ„3D ConvNetsзҡ„жҖ§иғҪеҫҲеӨ§зЁӢеәҰдёҠеҸ—еҲ°еҲҶиҫЁзҺҮзҡ„жҚҹеӨұе’Ңе‘ҲжҢҮж•°зә§еўһй•ҝзҡ„и®Ўз®—жҲҗжң¬йҷҗеҲ¶гҖӮеҗҢж—¶пјҢж·ұеәҰдј ж„ҹеҷЁзҡ„еҠ йҖҹеҸ‘еұ•д»ҘеҸҠиҮӘеҠЁй©ҫ驶жұҪиҪҰзӯүеә”з”Ёзҡ„е·ЁеӨ§йңҖжұӮдҪҝеҫ—й«ҳж•ҲеӨ„зҗҶ3Dж•°жҚ®жҲҗдёәеҪ“еҠЎд№ӢжҖҘгҖӮеҢ…жӢ¬ModelNet [37]пјҢShapeNet [8]пјҢ2D-3D-S [2]еңЁеҶ…зҡ„3Dж•°жҚ®йӣҶзҡ„жңҖж–°еҸҜз”ЁжҖ§еўһеҠ дәҶ3Dж•°жҚ®з ”究зҡ„жҷ®еҸҠгҖӮ

дёәдәҶйҒҝе…Қз®ҖеҚ•дҪ“зҙ еҢ–зҡ„зјәзӮ№пјҢдёҖз§ҚйҖүжӢ©жҳҜжҳҺзЎ®еҲ©з”ЁдҪ“зҙ зҪ‘ж јзҡ„зЁҖз–ҸжҖ§[35,21,11]гҖӮиҷҪ然зЁҖз–Ҹи®ҫи®Ўе…Ғи®ёжӣҙй«ҳзҡ„зҪ‘ж јеҲҶиҫЁзҺҮпјҢдҪҶе…¶иҜұеҜјзҡ„еӨҚжқӮжҖ§е’ҢеұҖйҷҗжҖ§дҪҝе…¶йҡҫд»Ҙе®һзҺ°еӨ§и§„жЁЎжҲ–зҒөжҙ»зҡ„ж·ұеәҰзҪ‘з»ң[30]гҖӮеҸҰдёҖз§ҚйҖүжӢ©жҳҜеҲ©з”ЁеҸҜдјёзј©зҙўеј•з»“жһ„пјҢеҢ…жӢ¬kd-tree [4]пјҢе…«еҸүж ‘[25]гҖӮеҹәдәҺиҝҷдәӣз»“жһ„зҡ„ж·ұеәҰзҪ‘з»ңжҳҫзӨәеҮәд»Өдәәйј“иҲһзҡ„з»“жһңгҖӮдёҺеҹәдәҺж ‘зҡ„з»“жһ„зӣёжҜ”пјҢзӮ№дә‘иЎЁзӨәеңЁж•°еӯҰдёҠжӣҙз®ҖжҙҒе’ҢзӣҙжҺҘпјҢеӣ дёәжҜҸдёӘзӮ№д»…з”ұ3з»ҙеҗ‘йҮҸиЎЁзӨәгҖӮжӯӨеӨ–пјҢеҖҹеҠ©иҝҗеҠЁз»“жһ„пјҲSfMпјүз®—жі•пјҢеҸҜд»ҘдҪҝз”ЁжөҒиЎҢзҡ„дј ж„ҹеҷЁпјҲеҰӮRGB-DзӣёжңәпјҢLiDARжҲ–常规зӣёжңәпјүиҪ»жқҫиҺ·еҸ–зӮ№дә‘гҖӮе°Ҫз®ЎзӮ№дә‘иў«е№ҝжіӣдҪҝз”ЁпјҢд№ҹиғҪеӨҹиҪ»жқҫиҺ·еҸ–пјҢдҪҶзӮ№дә‘иҜҶеҲ«д»»еҠЎд»Қ然具жңүжҢ‘жҲҳжҖ§гҖӮдј з»ҹзҡ„ж·ұеәҰеӯҰд№ ж–№жі•еҰӮConvNetsдёҚйҖӮз”ЁпјҢеӣ дёәзӮ№дә‘еңЁз©әй—ҙдёҠжҳҜдёҚ规еҲҷзҡ„пјҢ并且еҸҜд»Ҙд»»ж„ҸжҺ’еҲ—гҖӮз”ұдәҺиҝҷдәӣеӣ°йҡҫпјҢеҫҲе°‘жңүдәәе°қиҜ•е°Ҷж·ұеәҰеӯҰд№ жҠҖжңҜзӣҙжҺҘеә”з”ЁеҲ°зӮ№дә‘пјҢзӣҙеҲ°жңҖиҝ‘зҡ„PointNet [26]гҖӮ

е°Ҫз®ЎдҪңдёәе°Ҷж·ұеәҰеӯҰд№ еә”з”ЁдәҺзӮ№дә‘зҡ„е…Ҳй©ұпјҢPointNetд»Қж— жі•е……еҲҶеӨ„зҗҶеұҖйғЁзү№еҫҒжҸҗеҸ–гҖӮеҗҺжқҘPointNet++[28]иў«жҸҗеҮәжқҘйҖҡиҝҮжһ„е»әдёҖдёӘзұ»дјјйҮ‘еӯ—еЎ”зҡ„зү№еҫҒиҒҡеҗҲж–№жЎҲжқҘи§ЈеҶіиҝҷдёӘй—®йўҳпјҢдҪҶ[28]дёӯзҡ„зӮ№йҮҮж ·е’ҢеҲҶз»„зӯ–з•Ҙ并没жңүжҸӯзӨәиҫ“е…ҘзӮ№дә‘зҡ„з©әй—ҙеҲҶеёғгҖӮKd-Net [18]д»Һиҫ“е…ҘзӮ№дә‘жһ„е»әkdж ‘пјҢ然еҗҺиҝӣиЎҢд»Һж ‘еҸ¶еҲ°ж №иҠӮзӮ№зҡ„еҲҶеұӮзү№еҫҒжҸҗеҸ–гҖӮKd-NetжҳҺзЎ®ең°еҲ©з”ЁзӮ№дә‘зҡ„з©әй—ҙеҲҶеёғпјҢдҪҶжҳҜд»Қ然еӯҳеңЁиҜёеҰӮж„ҹеҸ—йҮҺдёҚйҮҚеҸ зӯүйҷҗеҲ¶гҖӮ

еңЁжң¬ж–ҮдёӯпјҢжҲ‘们жҸҗеҮәSO-NetжқҘи§ЈеҶізҺ°жңүеҹәдәҺзӮ№дә‘зҡ„зҪ‘з»ңдёӯзҡ„й—®йўҳгҖӮе…·дҪ“иҖҢиЁҖпјҢе»әз«ӢSOM [19]жқҘжЁЎжӢҹиҫ“е…ҘзӮ№дә‘зҡ„з©әй—ҙеҲҶеёғпјҢиҝҷдҪҝеҫ—еңЁеҚ•зӢ¬зҡ„зӮ№е’ҢSOMиҠӮзӮ№дёҠиҝӣиЎҢеҲҶеұӮзү№еҫҒжҸҗеҸ–жҲҗдёәеҸҜиғҪгҖӮжңҖз»ҲпјҢиҫ“е…ҘзӮ№дә‘еҸҜд»Ҙиў«еҺӢзј©жҲҗеҚ•дёӘзү№еҫҒеҗ‘йҮҸгҖӮеңЁзү№еҫҒиҒҡеҗҲиҝҮзЁӢдёӯпјҢйҖҡиҝҮеңЁSOMдёҠжү§иЎҢзӮ№еҲ°иҠӮзӮ№зҡ„k-иҝ‘йӮ»пјҲKNNпјүжҗңзҙўжқҘжҺ§еҲ¶ж„ҹеҸ—йҮҺйҮҚеҸ гҖӮзҗҶи®әдёҠпјҢSO-NetйҖҡиҝҮзү№ж®Ҡзҡ„зҪ‘з»ңи®ҫи®Ўд»ҘеҸҠжҲ‘们зҡ„зҪ®жҚўдёҚеҸҳSOMи®ӯз»ғжқҘдҝқиҜҒеҜ№иҫ“е…ҘзӮ№зҡ„йЎәеәҸдҝқжҢҒдёҚеҸҳгҖӮжҲ‘们зҡ„SO-Netзҡ„еә”з”ЁеҢ…жӢ¬еҹәдәҺзӮ№дә‘зҡ„еҲҶзұ»пјҢиҮӘеҠЁзј–з ҒеҷЁйҮҚе»әпјҢйӣ¶д»¶еҲҶеүІе’ҢеҪўзҠ¶жЈҖзҙўпјҢеҰӮеӣҫ1жүҖзӨәгҖӮ

дё»иҰҒиҙЎзҢ®еҰӮдёӢпјҡ

жҲ‘们и®ҫи®ЎдәҶзҪ®жҚўдёҚеҸҳзҪ‘з»ң - жҳҫејҸеҲ©з”ЁзӮ№дә‘з©әй—ҙеҲҶеёғзҡ„SO-NetгҖӮ

йҖҡиҝҮеңЁSOMдёҠиҝӣиЎҢзӮ№еҲ°иҠӮзӮ№зҡ„KNNжҗңзҙўпјҢеҸҜд»Ҙзі»з»ҹең°и°ғж•ҙж„ҹеҸ—йҮҺйҮҚеҸ жқҘжү§иЎҢеҲҶеұӮзү№еҫҒжҸҗеҸ–гҖӮ

жҲ‘们жҸҗеҮәдёҖз§ҚзӮ№дә‘иҮӘеҠЁзј–з ҒеҷЁдҪңдёәйў„и®ӯз»ғпјҢд»Ҙж”№е–„еҗ„з§Қд»»еҠЎдёӯзҡ„зҪ‘з»ңжҖ§иғҪгҖӮ

дёҺжңҖе…Ҳиҝӣзҡ„ж–№жі•зӣёжҜ”пјҢеңЁеҗ„з§Қеә”з”ЁдёӯиҺ·еҫ—зӣёдјјжҲ–жӣҙеҘҪзҡ„жҖ§иғҪпјҢ并且и®ӯз»ғйҖҹеәҰжҳҫи‘—еҠ еҝ«гҖӮ

е…ідәҺз”ЁдәҺзӮ№дә‘еҲҶжһҗзҡ„иҮӘз»„з»ҮзҪ‘з»ңSO-NetжҳҜжҖҺж ·зҡ„е°ұеҲҶдә«еҲ°иҝҷйҮҢдәҶпјҢеёҢжңӣд»ҘдёҠеҶ…е®№еҸҜд»ҘеҜ№еӨ§е®¶жңүдёҖе®ҡзҡ„её®еҠ©пјҢеҸҜд»ҘеӯҰеҲ°жӣҙеӨҡзҹҘиҜҶгҖӮеҰӮжһңи§үеҫ—ж–Үз« дёҚй”ҷпјҢеҸҜд»ҘжҠҠе®ғеҲҶдә«еҮәеҺ»и®©жӣҙеӨҡзҡ„дәәзңӢеҲ°гҖӮ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ